"Deepfake do bem"? Índia sai na frente na manipulação de vídeos eleitorais

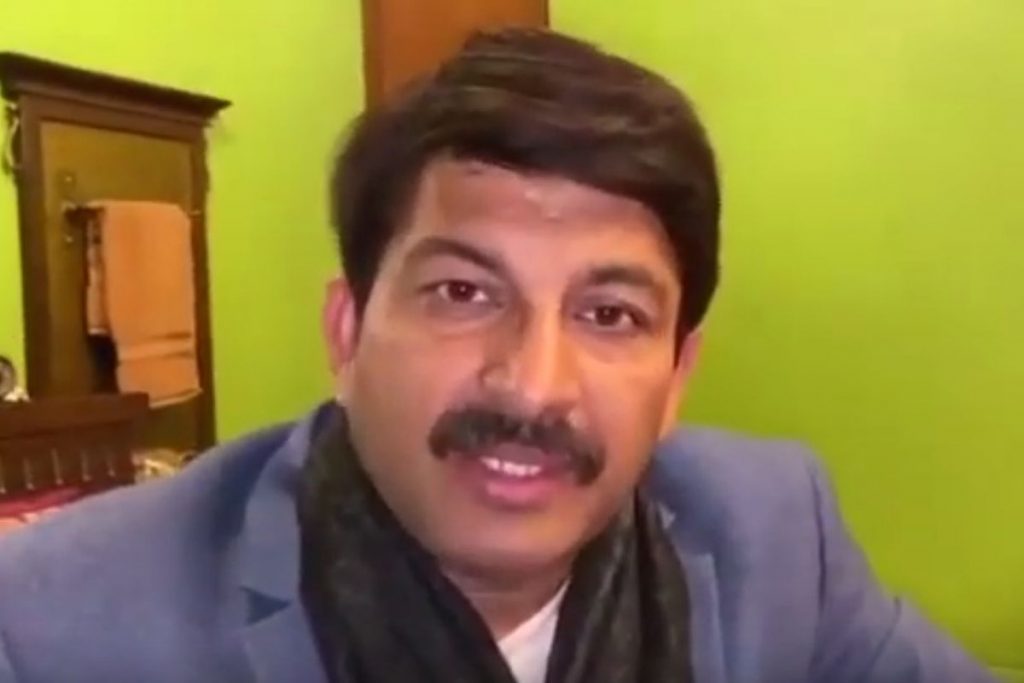

Manoj Tiwari, do partido indiano Bharatiya Janata, aparece em vídeo manipulado falando em dialeto que ele não domina (Reprodução)

A manipulação de vídeos para fins políticos não é novidade. O termo "deepfake", usado para designar o uso de aplicações de inteligência artificial para editar um vídeo, inserindo o rosto de uma pessoa ou sincronizando o movimento dos lábios, está por toda parte. Através desses vídeos o espectador menos cauteloso pode ver um candidato dizer e fazer coisas que ele jamais disse ou fez. A evidência visual faz a gente acreditar que aquele conteúdo é verdadeiro.

Popularizado através de um fórum na internet, esse tipo de vídeo adulterado encontrou na pornografia a sua primeira destinação. Multiplicaram-se pela rede os vídeos em que o rosto de uma atriz famosa era inserido no corpo compatível de uma protagonista de filme pornô.

Repercutiram também na internet nos últimos anos um discurso do Obama, um depoimento do Mark Zuckerberg, além de várias outras montagens. Nesses casos, o objetivo dos vídeos era alertar as pessoas sobre o que pode ser feito com a tecnologia. Por outro lado, vídeos do Bolsonaro vestido de Chapolin Colorado ou do ministro Moro dançando como uma melindrosa incorporaram a tecnologia para os fins de sátira.

Deixando a crítica e a sátira de lado, o uso mais comentado sobre os vídeos manipulados tem sido aquele que busca desinformar os espectadores, falseando a realidade e enganando a audiência. Geralmente esses vídeos inserem a vítima em um contexto falso, exibindo uma cena em que ela fala ou age de modo que pareça crível. Mas o que aconteceria se o deepfake não fosse usado contra a pessoa retratada no vídeo, mas sim a favor dela?

As eleições legislativas em Nova Déli, na Índia, parecem ter inaugurado uma nova fase na disseminação das deepfakes. Ao invés de manipular o vídeo para que um adversário faça ou diga alguma coisa, o partido Bharatiya Janata (BJP) manipulou uma gravação de seu próprio presidente, Manoj Tiwari, para que ele pudesse falar de forma convincente em Haryanvi, um dialeto hindi popular entre os eleitores que se procurava atingir.

No vídeo manipulado, o político faz duras críticas ao atual governo de Nova Déli, dizendo que ele "nos enganou com bases em promessas", mas que "agora Déli tinha a chance de mudar ao apertar o botão com a flor de lótus no dia 8 para formar um governo alinhado com o primeiro-ministro Modi". Uma versão em inglês também foi feita.

Este é o vídeo original:

Esta aqui a versão em inglês:

E esta a versão em Haryanvi:

O político não fala inglês (ou o dialeto Haryanvi) no vídeo original. Então a deepfake entrou em cena para fazer com que a voz de um dublador fosse sincronizada com os movimentos de lábio do político. Com isso, o vídeo parece convincente e fez com que a mensagem chegasse a um novo público.

Um representante do partido disse que, em grupos de WhatsApp, donas de casa comentavam sobre como "foi reconfortante ver o líder político falando o nosso idioma." Os vídeos adulterados alcançaram mais de 15 milhões de pessoas em cerca de 5.800 grupos de WhatsApp.

Parece fácil argumentar que essa deepfake seria menos lesiva do que aquelas que procuram inserir falsamente alguém em certo contexto. Afinal de contas, o que o video faz é apenas traduzir uma mensagem de forma mais eficiente do que a inserção de legendas ou de dublagem pura e simplesmente. Mas algo ainda parece errado nessa prática. Será que o vídeo deveria conter um aviso de que o seu conteúdo foi editado? Mas como fazer isso e ao mesmo tempo informar o espectador de forma simples e direta?

No Brasil, o interesse pelas montagens em vídeo enquadradas como deepfakes tem crescido. O próprio TSE já divulgou um material explicando sobre a possibilidade de manipulação de vídeos e alertando o eleitor para não compartilhar materiais que não se tenha certeza sobre a veracidade.

Vale lembrar que por aqui a Resolução nº 23.610/2019, do TSE prevê que a liberdade de expressão no período eleitoral pode ser restringida quando o eleitor "divulgar fatos sabidamente inverídicos" (art. 26 § 1º). Em artigo específico sobre o fenômeno da desinformação (art. 9º), a mesma resolução determina que a "utilização, na propaganda eleitoral, de qualquer modalidade de conteúdo, inclusive veiculado por terceiros, pressupõe que o candidato, o partido ou a coligação tenha verificado a presença de elementos que permitam concluir, com razoável segurança, pela fidedignidade da informação, sujeitando-se os responsáveis ao disposto no art. 58 da Lei nº 9.504/1997, sem prejuízo de eventual responsabilidade penal."

Como poderiam ser então as "deepfakes do bem" no Brasil? Embora a sincronização de movimentos do lábio para fazer com que o político fale outro idioma não seja tão crucial por aqui, já que não temos os mais de vinte idiomas oficiais que existem na Índia, esse recurso pode ser usado espertamente.

Imagine um discurso ou uma entrevista que cause controvérsia. Quer forma melhor de negar que o político tenha dito uma frase infeliz ou ofensiva do que fazer viralizar na rede uma versão manipulada na qual o trecho é suprimido ou adulterado? Uma vez causada a confusão, como saber quem está dizendo a verdade?

Ninguém deve estranhar se muito proximamente começarmos a ver uma guerra de versões em que cada lado da discussão apresenta a sua edição do mesmo vídeo. Tudo bem que políticos brasileiros dizem cada coisa que podemos questionar se não é a nossa própria noção de realidade que parece ter sido manipulada.

Por mais que a perícia técnica possa confirmar que um vídeo foi adulterado, a velocidade de disseminação nas redes de um conteúdo manipulado pode fazer com que os danos já tenham sido causados quando o resultado da checagem for divulgado.

É mais provável que os casos de deepfake que enfrentaremos pela frente serão para atacar um adversário político, fazendo com que ele diga ou faça algo que o coloque em uma situação de constrangimento frente ao seu eleitorado. De toda forma, vale ficar ligado no uso da tecnologia para manipular vídeos em favor da pessoa que nele aparece. Uma "deepfake do bem" pode fazer bem mal à saúde dos nossos processos políticos e eleitorais.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.