Foto ou fake? Por que as selfies estão cada vez mais artificiais?

Quer ter uma pele linda e suave? Tire uma selfie. (Foto: Unboxed Therapy)

A foto mais compartilhada em 2014 foi a selfie do Oscar. Para quem não se lembra, a apresentadora da cerimônia, Ellen DeGeneres deu a ideia de tirar a foto com vários atores e atrizes que estavam na plateia. Ela entregou o celular para o ator Bradley Cooper que, assumindo o comando da câmera frontal, clicou a selfie em que se espremiam onze estrelas de Hollywood, como Meryl Streep, Julia Roberts e Brad Pitt.

Jornais e agências de mídia republicaram a foto no dia seguinte. Muitas tomaram o cuidado de pedir a autorização da apresentadora. Mas será que pediram para a pessoa certa? Ellen teve apenas a ideia, mas foi Bradley Cooper que, ao montar o enquadramento e escolher o momento certo para clicar deveria ser reconhecido como o verdadeiro autor da foto.

Ninguém levou a sério, na época, a noção de que talvez o titular dos direitos autorais da foto pudesse ser também a Samsung, fabricante do celular usado para tirar a selfie. A empresa coreana apenas desenvolveu o hardware do celular, mas todo o trabalho criativo foi feito por um ser humano.

De 2014 para cá muita coisa mudou. As fotos e as selfies que tiramos todo dia continuam sendo o resultado de nossas decisões sobre enquadramento, luminosidade e pose, mas elas também resultam cada vez mais de escolhas feitas pelo software que roda em nossos celulares. O que você vê como produto final é o feliz resultado da união entre pessoa e máquina.

Mas nem sempre pessoa e a máquina podem concordar sobre como deverá ser a foto. Usuários do iPhone XS repararam que as selfies tiradas com o novo aparelho estavam suavizando marcas de expressão e imperfeições da pele. Essa "correção" feita pela câmera frontal é automática e vem como configuração padrão. Depois de protestos, a empresa prometeu corrigir a correção.

Nos últimos anos tem crescido o apelo por novidades nas câmeras dos celulares e muitos fabricantes, especialmente os asiáticos, investiram em hardware e em software para as "câmeras de selfie". São vários os casos em que o celular passou a afinar o rosto das pessoas, ajeitar a posição dos olhos e suavizar a pele.

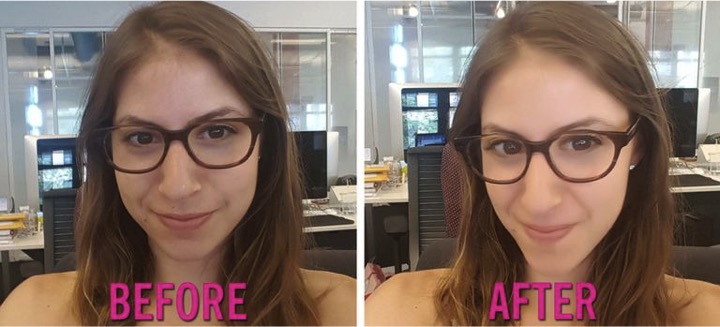

Em 2016, quando o "modo de beleza" das selfies tiradas pelos celulares Samsung ainda era uma novidade, a Cosmopolitan fez um teste com 13 mulheres usando o recurso em sua potência máxima. Como disse uma das voluntárias: "Isso deveria ser ilegal! Eu nem pareço uma pessoa normal". Outra afirmou que, se a moda pegasse, as lojas de cosméticos poderiam ir à falência. A revista também fez o teste com uma boneca Barbie e com a Monalisa, mas essas – por motivos distintos – não precisam de retoques digitais.

Teste da revista Cosmopolitan ligou o "modo de beleza" no máximo. (Foto: Cosmopolitan)

Quanto mais o resultado final de uma foto for criado a partir de melhorias inseridas automaticamente, será que ainda estamos de verdade no controle de nossas criações? Será que o que fotografamos ainda é a realidade, capturada por uma câmera, ou apenas uma ilustração, tipo uma arte gráfica, alterada por computadores para agradar o nosso senso estético?

Não estamos falando aqui de filtros que são escolhidos pela pessoa após tirar a foto. Uma foto com filtro não é mesmo a reprodução da realidade e todo mundo está bem ok com isso quando distribui coraçõezinhos no Instagram.

Esse cenário de manipulação automática das imagens ganhou um novo e espantoso capítulo com a câmera de visão noturna para os celulares Pixel, da Google, lançada no final de 2018. Batizada de "Night Sight" (visão noturna), a função das câmeras dos celulares Pixel permitem que o usuário tire fotos em ambientes de pouquíssima luz e, sem usar flash, faça a foto sair bem mais nítida. Que bruxaria é essa?

Antes de imaginar que os celulares da Google nos deram superpoderes para enxergar no escuro, vale entender como funciona o Night Sight. O que o celular faz é calcular a luminosidade do ambiente, perceber o quanto de ruído existe nos movimentos da mão que segura o aparelho e no espaço logo à frente, para então calcular a exposição, tirando até quinze fotos na sequência. Todas as fotos são então combinadas e retrabalhadas como em uma típica foto HDR para então serem remontadas por inteligência artificial, gerando assim uma única foto final.

Na remontagem da foto por inteligência artificial, o software procura iluminar o objeto retratado como se houvesse mais luz na foto. Nesse processo ele precisa entender como a luz poderia incidir sobre os objetos clicados e realçar cores que, a olho nu, nem mesmo eram vistas. O software assim revela como produto final algo que não existe na realidade (ou pelo menos não para o olho humano).

Foto normal e outra com o auxílio da visão noturna (sem flash). A diferença impressiona. Só faltou o Night Sight reconstruir o braço perdido do nosso Android de corda. Fica a dica. (Cortesia: Gabriel Aleixo)

Alguns experimentos com o night sight mostraram que o recurso chega a inserir novos elementos nas fotos, já que dada a pouca luminosidade o software precisa "adivinhar" o que estaria ali, completando a foto ou simplificando texturas. Geoffrey Fowler, escrevendo para o Washington Post, perguntou: "Até onde os telefones removerão nossas fotos da realidade? Podem os softwares nos treinar a achar que algo parece normal? Que partes das imagens deixaremos os computadores editarem? Em uma foto que tirei da Casa Branca (sem visão noturna), notei que os algoritmos do Pixel 3 treinados para suavizar as imperfeições realmente removeram detalhes arquitetônicos que ainda eram visíveis em uma foto no iPhone XS."

Isso não quer dizer que todos esses recursos, como modo de beleza e visão noturna, vieram ao mundo para estragar a fotografia. Ao contrário! Nós, que temos astigmatismo, saudamos a chegada da visão noturna e a morte do flash. Já vai tarde! Chega desse clarão de luz nos cegando em toda foto. Depois que Steve Jobs matou o Flash Player com uma cartinha e a DC matou o Flash com a Crise das Infinitas Terras, não esperávamos menos da Google.

Quando quase todos tem uma câmera na mão o tempo todo, o que se quer são fotos cada vez melhores com o mínimo de trabalho. Mas o que faz uma foto ser melhor? É a nitidez com que ela capta a realidade ao redor ou a conexão que temos com o seu resultado? Quanto mais as câmeras mostrarem como sendo foto algo que foi substancialmente alterado, mais difícil fica separar o real do artificial. Será que é isso que queremos? Fica a dúvida se não estamos misturando perigosamente as fronteiras entre o real e o artificial. Qual será o efeito a longo prazo se todas as fotos de celular passarem a ser automaticamente modificadas para nos agradar?

Talvez estejamos caminhando para um novo mundo da fotografia, em que a presunção é que nada do que é retratado é real. Será que sites de namoro vão proibir fotos tiradas com o "modo de beleza" ou essa distorção será normalizada?

Na última edição do concurso de Miss Universo, vencida pela representante das Filipinas, a candidata da Austrália contou uma piada no palco. Ela era mais ou menos assim: "Um otimista e um pessimista se encontraram em um bar. O pessimista disse: "As coisas simplesmente não poderiam piorar". O otimista disse: "Não mesmo! Claro que podem!""

Vamos então seguir o conselho e manter uma postura otimista sobre toda essa confusão. Longa vida ao "modo de beleza" e demais alterações digitais automáticas. Vai valer a pena trocar o sentido geral de realidade pela reconfortante ilusão de que todos têm enfim direito a uma pele de pêssego.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.